- Im Krieg zwischen Israel und dem Iran verbreiten sich Videos des Geschehens auch auf sozialen Medien.

- Neben echten Aufnahmen finden sich allerdings aus dem Kontext gerissene Videos oder KI-generierte Videos.

- Einfache Strategien und Werkzeuge helfen Ihnen dabei, Fakes zu erkennen.

Israel hat in der Nacht zum Freitag, den 13. Juni, einen großangelegten Luftangriff auf den Iran gestartet. Ziele waren nach israelischen Angaben Atomanlagen, militärische Einrichtungen und ranghohe Militärs. Der Iran reagierte mit Raketenangriffen, es gibt Tote auf beiden Seiten.

Wie häufig in unübersichtlichen Kriegssituationen verbreiten sich auf sozialen Netzwerken Bilder und Videos der Angriffe und ihrer Folgen. Ein Teil der Videos ist echt - andere wiederum sind aus dem Kontext gerissen oder mit künstlicher Intelligenz (KI) generiert. Der #Faktenfuchs erklärt anhand von drei Beispielen, was Ihnen in solchen Lagen dabei hilft, echte Bilder von Fakes zu unterscheiden.

KI-generierter Influencer vor Kriegstrümmern

Auf der Videoplattform TikTok kursieren derzeit Videos, die vermeintlich verheerende Zerstörungen in Israel zeigen sollen. Es stimmt, dass iranische Raketen an mehreren Orten in Israel einschlugen, Gebäude beschädigten oder zerstörten und Menschen töteten. Gleichzeitig verbreiten sich allerdings Videos, die mit künstlicher Intelligenz generiert wurden.

Ein Video beispielsweise zeigt einen KI-generierten Mann, der sich mit einem Selfiestick selbst filmt. Hinter ihm liegen Trümmer von Gebäuden und kaputte Autos, es raucht und brennt. Er trägt ein Hawaii-Hemd, um seinen Hals trägt er ein Band, an dem ein "Besucherausweis" hängt.

Das Video wirkt auf den ersten Blick realistisch. Die Programme, mit denen Nutzer künstliche Videos mithilfe einer Texteingabe selbst generieren können, verbessern sich stetig. Die neuesten KI-Videos sind immer schwieriger auf den ersten Blick zu entlarven. Fehler wie zum Beispiel Körperteile, die mit der Umgebung verschmelzen, kommen immer seltener vor.

Noch wichtiger wird daher bei der Erkennung von KI-Fakes schlichte Logik: Wie wahrscheinlich ist es, dass ein Influencer in sauberer Strandkleidung freudestrahlend in einer Szenerie steht, in der offensichtlich erst kurze Zeit vorher Bomben oder Raketen eingeschlagen sind? Würde er nicht nach Schutz suchen? Kurzes Innehalten und Nachdenken führt im Falle dieses Videos rasch zu berechtigten Zweifeln an der Authentizität des Videos.

Auf den zweiten Blick fallen weitere Unstimmigkeiten auf: Auf dem "Besucherausweis" des Influencers ist ein Rechtschreibfehler, statt "visitor pass" steht dort "visitor pas". Am auffälligsten aber sind die Untertitel des Videos. Sie zeigen Buchstabenabfolgen, die nur vage an das erinnern, was der Influencer sagt. KI-Modelle haben nach wie vor große Probleme damit, Texte in Videos akkurat zu erzeugen.

Diesen Influencer gibt es nicht. Das angeblich in Tel Aviv aufgenommene Video ist KI-generiert.

Weitere Informationen deuten darauf hin, dass es sich um ein Video handelt, das auf sarkastische Art eine propalästinensische und antiisraelische Haltung transportiert. Beispielsweise die Aussage des Influencers: "Shalom aus Tel-Aviv. Heute gebe ich euch eine geführte Tour darüber, was passiert, wenn man andere Länder aus Spaß bombardiert und überrascht spielt, wenn sie zurückschießen." Der Account, der das Video veröffentlichte, postete dazu Hashtags wie "#FreePalestine" oder "#GazaUnderAttack".

Im zweiten Teil des Videos wird noch deutlicher, dass es sich um einen politisch motivierten Fake handelt. Dort sieht man einen Mann mit einer Kippa, der ebenfalls vor einem Trümmerhaufen steht und sagt: "Dank deiner Unterstützung haben wir Kriegsverbrechen seit 1948 ignoriert." Der Mann nimmt einen Schluck aus einem Kaffeebecher, seine Lippen bewegen sich nicht mehr - aber die Tonspur seiner Stimme geht ununterbrochen weiter.

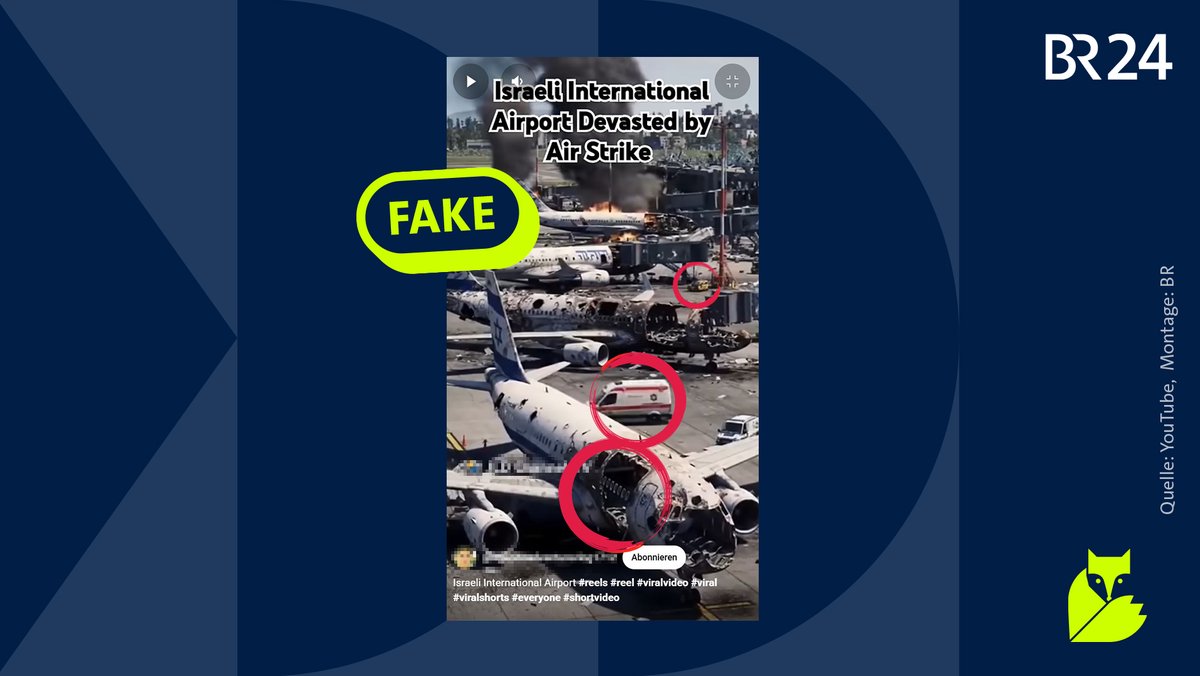

Video zerstörter Flugzeuge ist KI-generiert

Ein weiteres Fake-Video auf mehreren Plattformen soll einen Flughafen in Israel darstellen, wo fünf zerstörte Flugzeuge auf einem Rollfeld stehen. Dem Augenschein nach haben dort zuvor Explosionen stattgefunden, die Flugzeuge erscheinen ausgebrannt, es ist Rauch zu sehen, Krankenwagen fahren durch das Bild. Auf den Heckflossen der Flugzeuge sind Davidsterne aufgemalt, sie sind gestaltet wie die Flugzeuge der israelischen Fluggesellschaft "El Al". Verschiedene Indizien deuten aber darauf hin, dass das Video künstlich generiert wurde - dazu gleich mehr.

In diesem Fall ist die schnellste Möglichkeit, das Video zu prüfen, eine kurze Internetrecherche. Denn: Wären tatsächlich auf einem israelischen Flughafen fünf Flugzeuge zerstört worden, hätten deutsche, israelische und andere internationale Medien darüber berichtet. Entsprechende Berichte findet man jedoch nicht - lediglich Berichte darüber, dass die Fluggesellschaft El Al ihre Flugzeuge außer Land geflogen hat, um sie vor iranischen Angriffen zu schützen. Entsprechend strich die Airline vorerst auch alle Flüge. Eine #Faktenfuchs-Anfrage dazu blieb von El Al bisher unbeantwortet.

Verschiedene Indizien deuten zudem darauf hin, dass das Video KI-generiert wurde. Es ist stark weichgezeichnet - ein typisches Merkmal KI-generierter Videos.

Ein besonders klarer Hinweis auf einen KI-Fake: Die Passagierfenster der vorderen beiden Flugzeuge schweben scheinbar in der Luft an Stellen, an denen im Video eigentlich Löcher in die Rümpfe der Flugzeuge gerissen sind. Außerdem scheinen sich die Krankenwägen in der gleichen Geschwindigkeit zu bewegen. Einer der Krankenwägen fährt in der gleichen Position sogar zweimal durch das Bild.

Auffällig ist auch, dass die Größenverhältnisse der Autos auf dem Rollfeld unrealistisch wirken. Israelische Krankenwagen haben auf anderen Bildern nur einen roten Streifen - während die Krankenwagen in dem Fake-Flughafen-Video zwei rote Streifen haben. Ein gelbes Auto im Video sieht ungewöhnlich zerknautscht aus, hier hat die KI vermutlich einen weiteren Fehler gemacht.

Mit hoher Wahrscheinlichkeit ist das Video mit künstlicher Intelligenz generiert worden. Sicher ist: Das Flughafen-Video zeigt kein echtes Material aus dem Krieg zwischen Israel und dem Iran im Juni 2025.

Mehrere Merkmale deuten darauf hin: Dieses Video von zerstörten israelischen Flugzeugen ist ein KI-generierter Fake.

Video zeigt Raketenangriff Irans auf Israel im Oktober 2024 - nicht heute

Eine einfache Technik, um Falschinformationen zu verbreiten, ist die Verwendung von altem Bild- oder Videomaterial. Dann wird behauptet, das alte Material zeige aktuelle Geschehnisse. Diese Technik nennt man "falsche Verknüpfung". In Krisen- oder Kriegssituationen passiert dies regelmäßig, zum Beispiel nach dem Angriff der Hamas auf Israel, wie man in diesem #Faktenfuchs nachlesen kann.

Derzeit kursiert ein Video, das mit folgender falscher Behauptung verknüpft ist: Es zeige iranische Raketen, die auf Israel abgefeuert würden. Mit einer Bilderrückwärtssuche lässt sich aber feststellen: Das Video ist nicht aus dem Juni 2025, sondern es ist mindestens neun Monate alt.

Zum Beispiel findet man einen Beitrag auf der Plattform X, in dem dasselbe Video schon am 01. Oktober 2024 verwendet wurde. Auf der Webseite eines israelischen Mediums, ebenfalls von vor neun Monaten, sieht man dasselbe Video. Der deutsche Nachrichtensender n-tv verwendete das Videomaterial am 03. Oktober 2024. Bereits am ersten Oktober 2024 hatte Iran Israel mit Raketen angegriffen, nachdem Israel den politischen Führer der Hisbollah sowie einen Kommandeur der Hisbollah umgebracht hatte. Dass es sich um ähnliche Ereignisse handelt, die ähnliche Bilder hervorbringen, kann zur Verbreitung dieser falschen Informationen beitragen.

Dieses Video auf X zeigt, anders als behauptet, keine aktuellen Raketenangriffe des Irans auf Israel. Die Aufnahmen sind vom Oktober 2024.

Aus dem Kontext gerissene und alte Fotos und Videos kann man häufig mit einer Bilderrückwärtssuche entlarven. Eine Bilddatei oder die URL zu einem Bild kann man in einer Bilderrückwärtssuchmaschine wie Google, TinEye oder Yandex eingeben. Besonders bei weit verbreitetem Material kann man so schnell die Information überprüfen.

- Mehr Tipps dazu, wie Sie Fakten selbst prüfen können, lesen Sie hier.

Fazit

Israel und der Iran greifen sich nach einem Erstschlag Israels gegenseitig an, unter anderem mit Raketen und Drohnen. Im Netz kursieren Videos, die die Beschüsse und ihre Folgen zeigen sollen. Einige Aufnahmen sind echt, andere sind aus dem Kontext gerissen oder mit künstlicher Intelligenz generiert.

Einfache Logik, kurze Recherchen und Bilderrückwärtssuchen helfen in solchen Situationen, echtes Material von Fakes und aus dem Kontext gerissenen Videos zu unterscheiden.

Quellen:

Abu Ali Express: Iran: Gleichzeitiger Start aus der Gegend von Täbris

Aero Telegraph: El Al, Arkia, Israir und Air Haifa streichen Flüge noch länger

Aero Telegraph: Israelische Airlines schaffen ihre Flugzeuge aus dem Land

BR24 #Faktenfuchs: Bilder und Videos aus Israel im Check

BR24 #Faktenfuchs: Wie Sie Fakten selber prüfen können

ntv: USA warnen Israel vor Luftschlägen gegen Irans Atomanlagen

Tagesschau: Das Ende der Wirklichkeit?

Tagesschau: Explosionen in Teheran - iranische Angriffe wohl ohne größere Schäden

Tagesschau: Iranische Rakete trifft Zentrum von Tel Aviv

Tagesschau: Israelische Armee gibt vorerst Entwarnung

Tagesschau: Tod von Hisbollah-Chef Nasrallah bestätigt

Disclaimer, 18.06.2025, 14:15: Dieser Artikel wurde erstmals am 17.06.2025 um 17:33 Uhr veröffentlicht. Wir haben die Überschrift konkretisiert und den Zeitstempel angepasst.

Das ist die Europäische Perspektive bei BR24.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!